Uma discussão antiga em relação aos veículos autônomos é a questão ética: em caso de uma falha geral no veículo e uma ação emergencial ser necessária, qual é a forma correta de agir? Sacrificar os passageiros ao não evitar uma colisão ou desviar o veículo e atropelar pedestres?

São dilemas teóricos que pertencem mais ao campo da filosofia do que da tecnologia, mas que precisarão ser estudados mais profundamente quando as empresas começarem a colocar os carros autônomos nas ruas. Afinal de contas, hoje a responsabilidade das ações cai nos ombros do motorista, que reage por instinto em situações de emergência. Quando a máquina for responsável pelas decisões, a programação desses sistemas precisará prever uma simulação de reação instintiva.

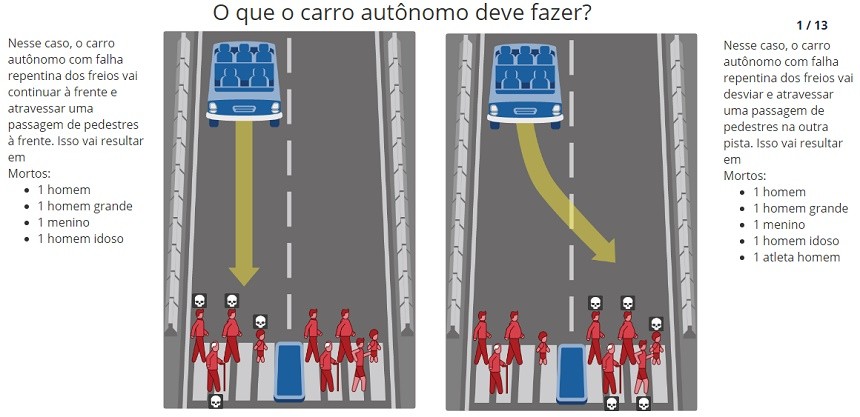

Para entender qual seria a melhor forma de agir em uma situação em que não há uma resposta fácil, o MIT criou uma espécie de teste (ou jogo, se preferir) que traz vários dilemas morais sobre como e quem matar em um caso extremo. A Máquina Moral do MIT, como é chamado o teste, traz vários cenários fatais, e o usuário precisa decidir qual é o modo certo de agir.

Os casos são os mais variados possíveis, e algumas situações são mais racionalizáveis que as outras. Por exemplo: entre bater um carro com dois idosos ou atropelar quatro crianças, qual seria a melhor opção? É possível que você tenha uma visão diferente da minha, mas eu preferiria salvar as crianças por terem mais tempo de vida pela frente. Outras perguntas são mais difíceis de racionalizar, como bater o carro com três mulheres ou atropelar três mulheres obesas. O teste pode ainda jogar algumas outras variáveis, como a possibilidade de os pedestres estarem atravessando a rua com o semáforo vermelho.

O teste está disponível em português neste link. Para começar a responder o questionário, basta pressionar o botão “Comece a julgar”.

Por que o teste?

O MIT diz que o avanço dos veículos autônomos exige não apenas mais clareza sobre como humanos fazem as escolhas, mas também mostra como é importante compreender a nossa percepção sobre uma inteligência artificial fazendo essas escolhas éticas.

De acordo com a página, o teste tem como objetivo levar a discussão adiante criando uma plataforma para “construir colaborativamente um retrato da opinião das pessoas sobre como as máquinas devem tomar decisões quando confrontadas com dilemas morais e gerar uma discussão coletiva sobre as consequências morais desses cenários em potencial”.

Em outras palavras, cuidado com o que você responde, já que é possível que os resultados do estudo um dia sejam usados para embasar comportamentos de inteligências artificiais em situações reais de emergência.

Fonte: Olhar Digital